ゲームエンジン“Unity”の開発者向けイベント「Unite Tokyo 2018」が5月7日から9日まで、東京国際フォーラムで開催されました。ここではこのイベントから「AniCast!東雲めぐちゃんの魔法ができるまで」をレポートします。

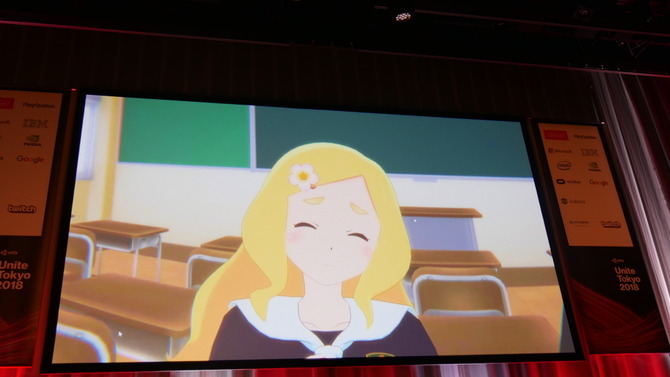

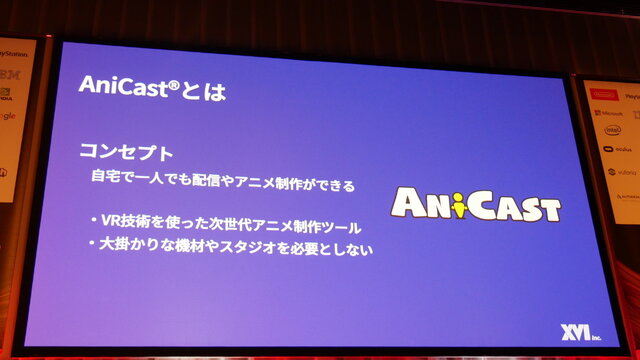

東雲めぐちゃんは高校1年生のバーチャル配信者。SHOWROOMを活動拠点として月曜から金曜日の朝7:30、日曜日の19:00から生配信を行っています。キャラクターデザインはアニメキャラクターのVRコンテンツを手掛けるGugenka by CS-REPORTERSが担当。キャラクターを動かすシステム「AniCast」をGOROmanこと近藤義仁氏が率いるXVI(エクシヴィ)が開発しています。

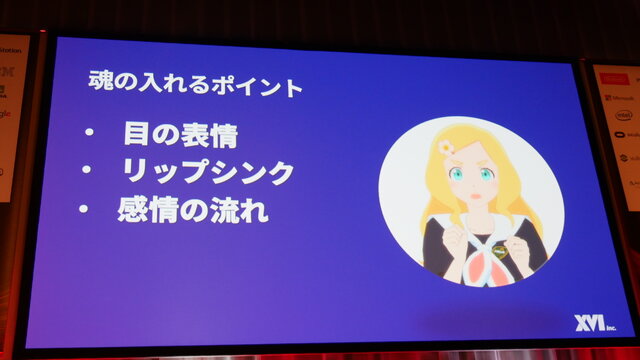

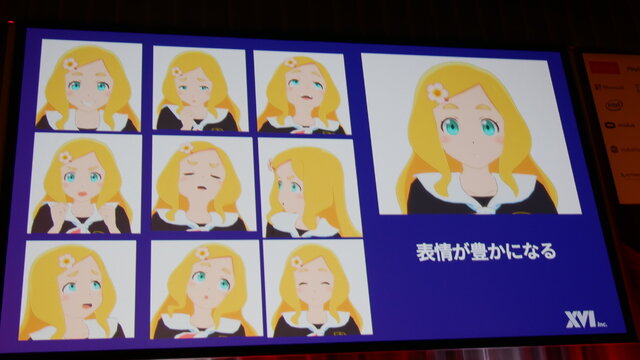

講演はGOROman氏の軽快なトークにより各パートの責任者が話す、という形式で進行しました。まずは室橋氏によるキャラクターに「魂を込める話」。めぐちゃんの表情についての説明をしました。

特に大事な表情のポイントとして、「目の表情」「リップシンク」「感情の流れ」があり、「目の表情」については眼球を動かすとそれに伴ってまわりの筋肉も一緒に動くということ。この動きを取り入れることでキャラクターが生き生きとするほか、AniCastではこれを自動的に入れられるとのこと。なお、ロボットやアンドロイドのような人間味のない表現をするときはこれをOFFにすると良い、という話も飛び出しました。

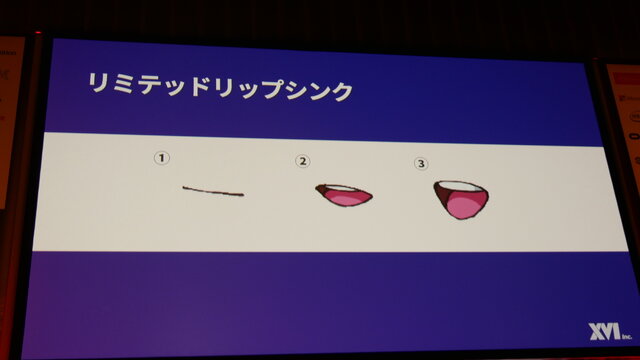

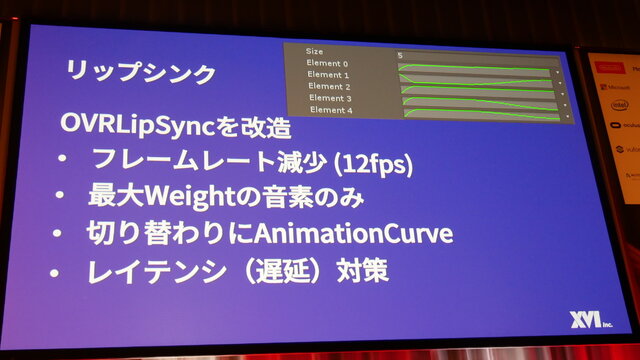

「リップシンク」はOculusが提供するリップシンクライブラリを使っており、これを使うとなめらかな動きになるのですが、めぐちゃんの場合はアニメっぽい表現をしたい、ということで、アニメーションのカーブを調整して実現しています。この話は後述の吉高氏のパートで詳しく説明します。

また、アニメ表現ということで、演者が見るVR内の画面は90FPSで表示されていますが、2D表示されるキャラクターアニメーションは12FPS、背景は30FPSで画面出力されている、ということです。このフレームレート調整で日本のリミテッドアニメ的な表現を実現しています。これを応用すると海外アニメなら24FPS、ゲーム的なら30FPSというのもアリなのでしょうか。

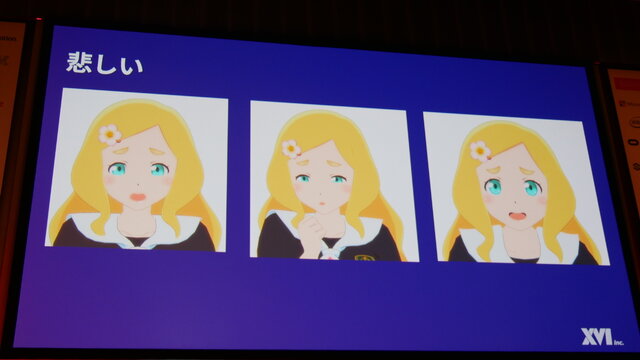

話を戻しまして、「感情の流れ」について。8つの感情で構成された「感情の輪」があって、反対の感情(例えば喜びから悲しみなど)に動かすには大きな反応が必要になり、表情の変化も感情の変化で変わりやすいところとあまり変わらないところの見極めが必要になるそうです。

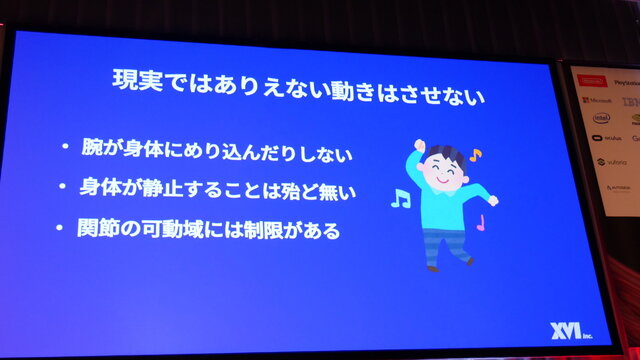

次に狩野氏によるプレゼンス(実在感)の話。プレゼンスは過去のVR系の講演ではVRの世界を現実に見せる、ということで、これがはがれるといわゆる魔法が解けちゃう、という状態になるので、それを技術面でどのような工夫をしたかを講演しました。

AniCastでは現実的な動きをさせるということにこだわっています。骨折しちゃうような動きはさせない、人間の体がぴったり静止することはない、関節の可動域には制限があるので無理のある動きはさせない、というのが注意点となります。

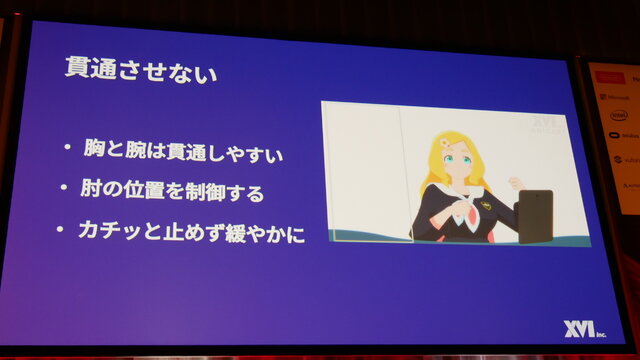

AniCastではFinal IKというアセットを使ってIK制御でキャラクターの動きを制御しているのですが、肘が胸にめり込んでしまうことが問題になりました。さらにOculus Touchでは手の位置は検知できますが、肘の位置を検知できないため、肘の動きはプログラム側でめり込まないように制御しています。

キャラクターの硬さをなくす、というところでは「人の体はしなる」ことや「動きに慣性が働く」ところを意識して動くようにプログラムしているそうです。

変な動きを抑えるという点では、やはりIK制御では肘の位置が問題となる、ということで手の位置を基準にして予測される肘の位置を導き出して動きを生成しています。

プレゼンスを高めるために試してみたけどボツになったネタも紹介されました。

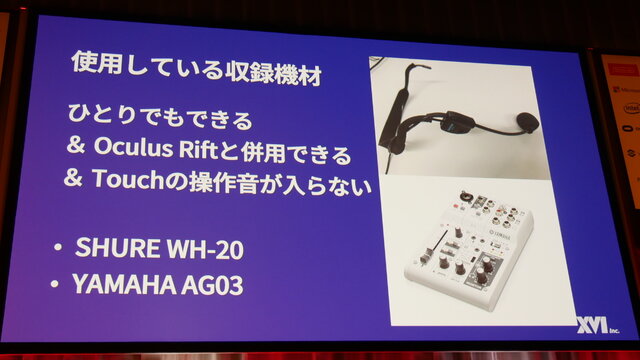

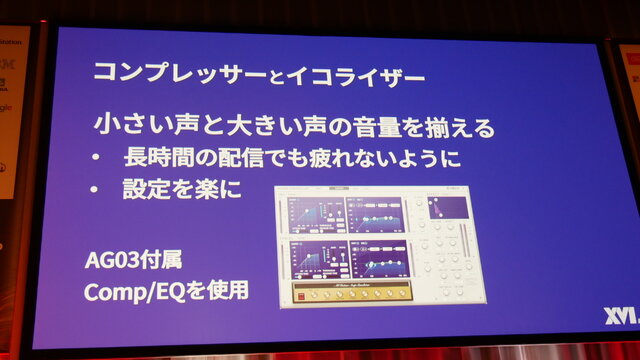

続いて音の話題を吉高氏から説明。収録機材はOculus Touchの操作音が入らないように首に巻いて口元の音のみを拾うヘッドセットマイク(Shure WH-20)とYAMAHAのミキサーAG03を使用しています。「一人で簡単に使える」ということが前提の機材となっています。

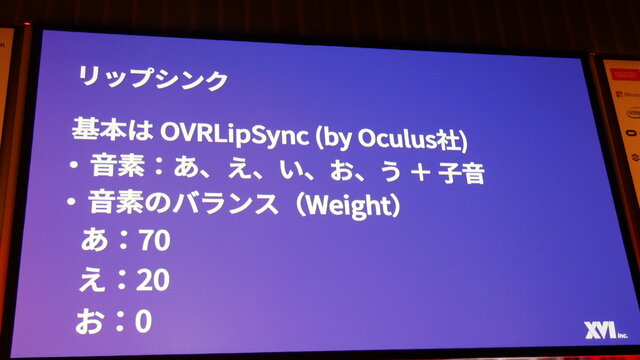

リップシンクの技術的な話題に移ります。基本となるソフトウェアはOculusのOVRLipSyncライブラリを使用します。これは入力された音声の音素のウェイトを返すというものです。このままでもいい感じで口が動くのですが、室橋氏から猛烈なアピールがあり、いろいろな改造をすることになりました。

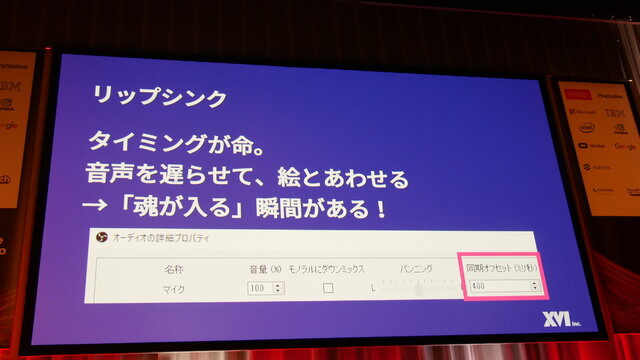

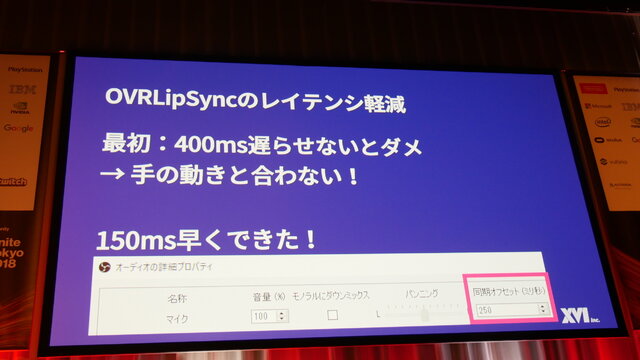

しかし、それでも魂が入らなかったそうで、その理由は「遅延(レイテンシ)」。プログラムの仕組みとして、音声情報をバッファリングして入力するのでずれが発生してしまいます。ちなみにこれはWindowsのオーディオ・マイク入力のプロパティで遅延設定を変更できる、とのことですが……。

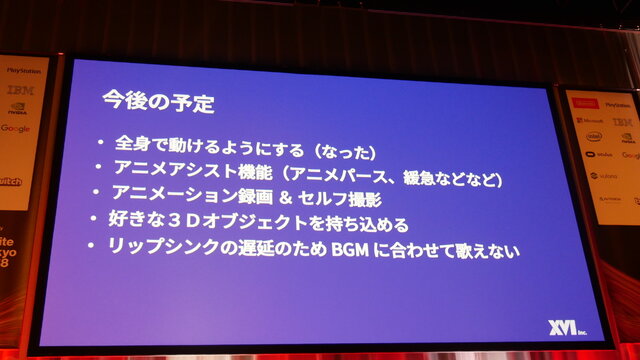

今後はアニメパースの実現やセルフ撮影機能、歌対応(リップシンクの遅延がまだ250ms・1/4秒あるのでテンポが遅れる)などを予定しています。

というところで、GOROman氏にマイクが戻り(基本的にフリは氏がやってましたけど)、「Vtuberをこれから生み出す方は、キャラクターを生み出す以上、大事に長く運用していってほしい。キャラクターを生み出した責任は発生すると思うので、末永くやれるようにしてほしい」と語り、講演をしめくくって質疑応答に……

と思いきや「今回、アレっと思いませんか、キズナアイちゃん(7日の基調講演にビデオで出演)とか、シロちゃん(関連記事)とか、出演者にいるのにあれ録画じゃんって!」と話して(この愛のあるDisり方がGOROman流! 多分)、なんといきなりめぐちゃんを学校からZOOMというメッセンジャーアプリを使って呼び出すことに!

最後にGOROmanさんのPCのバッテリーが切れかけてめぐちゃんの顔に警告ウインドウが重なる、という放送事故(笑)があったものの、今回の講演はバーチャルキャラクターの未来を垣間見せたものになったことは間違いないことでしょう。