パシフィコ横浜ノースの現地とオンラインの両面で実施された、ゲーム開発者向け大規模カンファレンスCEDEC2023。『FF16』においてリモートワーク環境でどのようにモーションキャプチャを行ったかを語る「FINAL FANTASY XVI:おうちDEモーションキャプチャ」のセッションレポをお届けします。

本セッションには、スクウェア・エニックスの第三開発事業本部アニメーターである佐藤逸人氏と、テクニカルアーティストの髙田英治氏が登壇しました。

モーションキャプチャはリモートワークに対応出来るの?

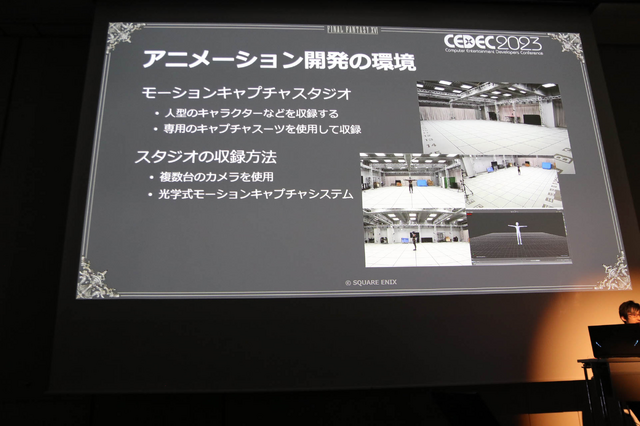

コロナ禍が始まった2020年を境に、モーションキャプチャのリモートワーク環境を整えなくてはならなくなりました。通常は、広いモーションキャプチャスタジオで人型キャラクターなどを専用のキャプチャスーツを使用して収録。さらにプロのアクターさんが参加して迫力のある演技を撮影してゲーム内で使用しています。スタジオでは複数台のカメラや光学式モーションキャプチャシステムを使うほどです。

リモートワークならではの利点を生かした働き方をすすめようと考えて、スタジオがある東京近辺に住んでいないチームメンバーでも収録ができたり、ディレクションができるような環境を取り組み始めたのです。そのためリモート環境とモーションキャプチャスタジオを両立する新しい収録方法を試したことが今回のセッションの内容となります。

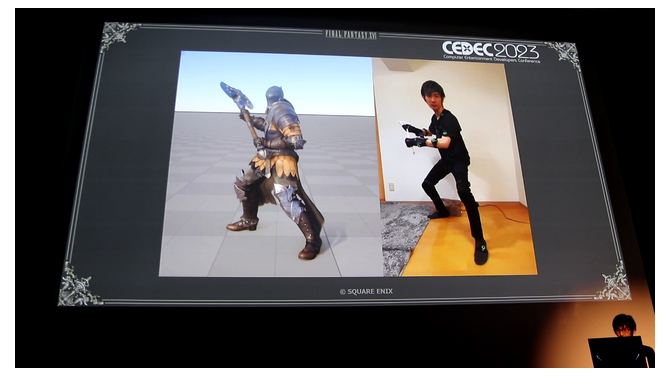

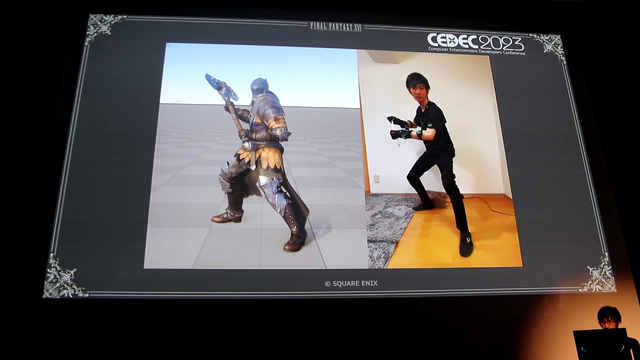

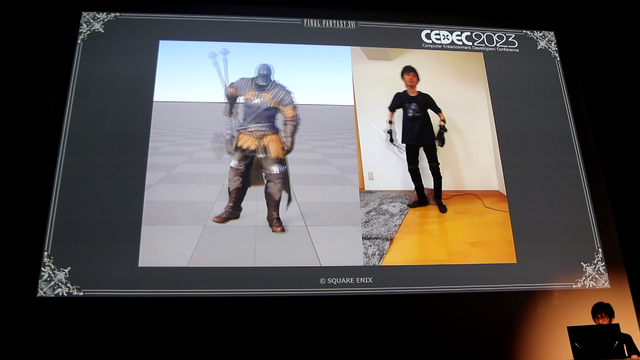

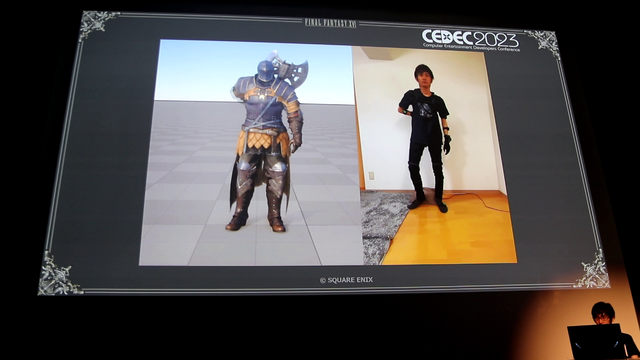

ここではモーションキャプチャの様子を披露。狭い場所で撮影しているために画角が収まりきりませんが、マンションでの騒音対策としてクッションを敷いたことや、布団叩きを使って納刀アニメーションを撮影しました。

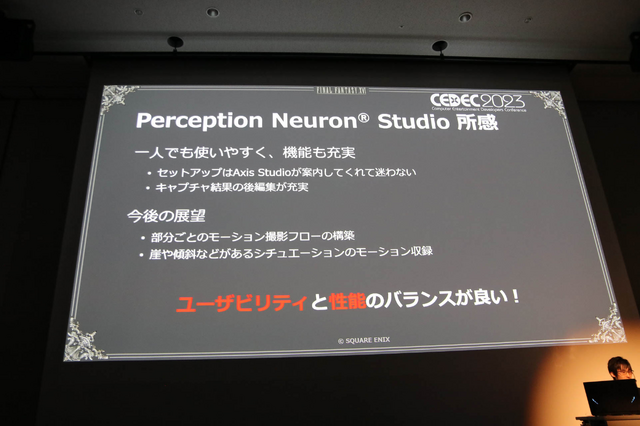

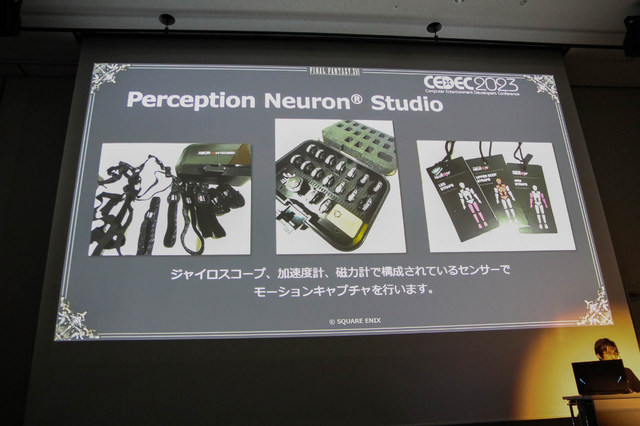

モーションキャプチャ体制を自宅で構築するには様々な方法がありますが、今回は加速度センサーを用いた「Preception Neuron Studio」と、動画からキャプチャデータを作成する「MediaPipe」の2種類を使用。6個のセンサーを身体に装着するフルトラッキングの「mocopi」は、残念ながら開発がほぼ終わった2023年初頭にリリースされた製品であるために検証までに留めています。

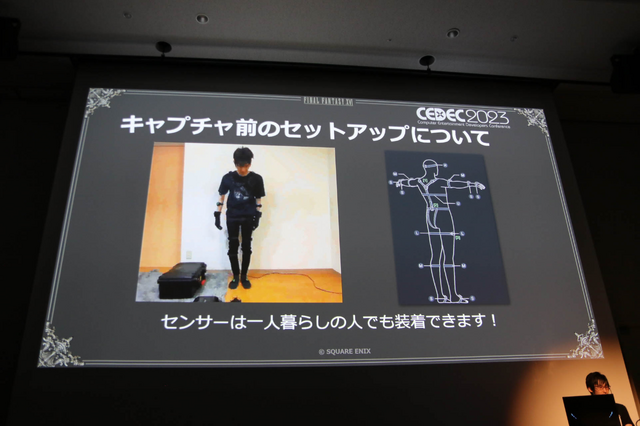

「Preception Neuron Studio」は、ジャイロスコープと加速度センサー、磁力計で構成されているセンサーでモーションキャプチャを行います。この機器が選ばれたのは、装着が1人で取り付けられるためだったためです。

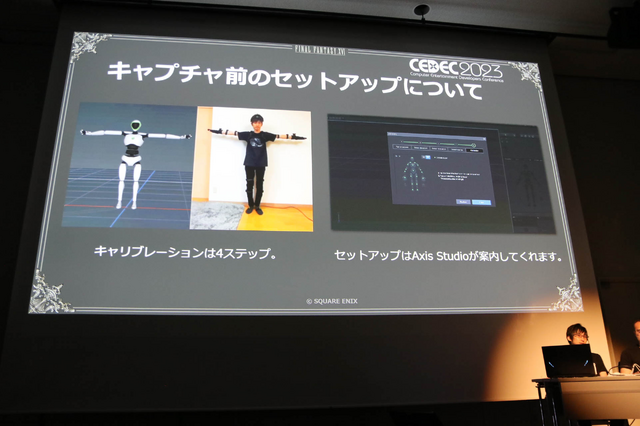

センサーは充電式なためコードが絡まることはありませんが、数の多さから6分半ほど時間が必要です。キャリブレーションは、素立ちとTポーズ、手を合わせるポーズ、物を摘まむポーズの4つを行うことで完了。セットアップはAxis Studioで行えます。

撮影データからリグに流し込むフローは、キャプチャ結果を受信するAxis Studioでアニメを出力→Maya HumanIKでリターゲット→Maya HumanIKのリグ流込ツール(3Dモデルは確認用のものを使用)→社内リグシステムの4工程です。

ここで納刀モーションを披露。仮のモデルからゲームで使うモデルまで、正確な形でアニメーションを実装しているのがわかりました。またリモート環境であってもその様子を画面上に共有して映せることから大活躍だったそう。ミーティング中にリアルタイムで撮影状況を確認しフィードバックを受けて、ミーティング後にキャプチャデータをスグ共有することや、撮り直しも即行えるので安心感もある実用的で楽しい手法であったと語ります。

また手のみのアニメーションも撮影可能ですが今回は使用しなかったそう。カットシーンにおける手のクローズアップを撮影する必要性が出てくると予想できるために、今後は様々な部位のみの撮影にも挑戦したいと述べます。